Josep Marco-Pallarés y Juan Lupiáñez tuvieron la amabilidad de invitarme a dar un seminario en los másteres que dirigen en la Universitat de Barcelona y la Universidad de Granada, respectivamente. Intenté convencer a los estudiantes de que no deben creerse todo lo que lean en un artículo y les enseñé algunas herramientas estadísticas sencillas que permiten evaluar críticamente cómo de creíbles son los resultados de un estudio. Entre otras cosas, vimos cómo analizar la distribución de valores p, cómo hacer un funnel plot y cómo usar el test de exceso de resultados significativos. Si te interesan estos temas, puedes encontrar información sobre todas estas técnicas en las diapositivas del curso, incluyendo el código necesario para hacer los análisis en R y enlaces a otras aplicaciones online para detectar sesgos.

Author Archives: Miguel A. Vadillo

Entrevista para El Mcguffin Educativo

Siempre me ha sorprendido que a los escépticos de nuestro país les preocupen tanto la homeopatía y las flores de Bach -que al fin y al cabo son libres de tomar o no- y sin embargo permanezcan indiferentes ante las prácticas pseudocientíficas a las que, lo quieran o no, someten a sus hijos en las escuelas. Es difícil encontrar una escuela donde no se utilicen los bits de inteligencia de Doman, basados en la idea de que con la estimulación adecuada, cualquier niño de menos de uno año de edad puede aprender a escribir, sumar y restar. Bajo el nombre de HERAT acaba de llegar a nuestro país un programa educativo que en el resto de los países se conoce como Brain Gym y se basa en ideas felices como que los niños aprenden mejor si beben seis vasos de agua al día (porque “la comida procesada no tiene agua”), o si se tocan los lóbulos de las orejas de cierta manera para favorecer la conexión de los hemisferios cerebrales a través del cuerpo calloso. No pasa nada si tu hijo tiene problemas de dislexia, autismo o TDAH –que por cierto, no existe– porque disponemos de sencillos métodos que curan todo esto y más a base de hacer ejercicios de percusión o escuchando música manipulada electrónicamente. Lógicamente, los cursillos donde se enseña esto hacen furor entre el profesorado. Los niños del siglo XXI ya no son introvertidos o extrovertidos; no se les dan bien o mal las matemáticas. Ahora son de hemisferio izquierdo o de hemisferio derecho; visuales, kinestésicos o auditivos; tienen inteligencias múltiples, cada uno las suyas. De hecho, los niños son ahora tan diferentes los unos de los otros que ya sólo tienen una cosa en común: Todos son genios. En fin. Entre tanta tontería sólo hay un puñado de valientes que se atreve a decirle al emperador que va desnudo. Y entre ellos, Albert Reverter brilla con luz propia. Así que cuando me preguntó si me dejaría entrevistar para su blog, El Mcguffin Educativo, la respuesta fue sencilla. El resultado, aquí.

Entrevista para UDIMA

Cada vez que quedo con Carmelo para tomar algo y charlar un rato, no sé si llegamos a solucionar los grandes problemas del mundo, pero a mí me parece que todo va un poco mejor. Nuestras conversaciones pierden algo de gracia si no tenemos delante una cerveza o una ración de bravas que nos hagan de espectadoras y comenten la jugada. Aun así, Carmelo quiso entrevistarme formalmente para la UDIMA y esto es lo que salió. Debo decir que sólo estoy de acuerdo con el titular los días impares, pero hoy lo es.

Cognitive biases, error management theory, and the reproducibility of research findings

The human mind is the end product of hundreds of thousands of years of relentless natural selection. You would expect that such an exquisite piece of software should be capable of representing reality in an accurate and objective manner. Yet decades of research in cognitive science show that we fall prey to all sorts of cognitive biases and that we systematically distort the information we receive. Is this the best evolution can achieve? A moment’s thought reveals that the final goal of evolution is not to develop organisms with exceptionally accurate representations of the environment, but to design organisms good at surviving and reproducing. And survival is not necessarily about being rational, accurate, or precise. The target goal is actually to avoid making mistakes with fatal consequences, even if the means to achieve this is to bias and distort our perception of reality. Read the post in Imperfect Cognitions.

¿Sirve de algo entrenar la memoria de trabajo?

Dice la canción que tres cosas hay en la vida: salud, dinero y amor. Si hubiera que añadir una cuarta, mi voto va para la memoria de trabajo (MT). Es uno de esos constructos mágicos que parece predecirlo casi todo en la vida: capacidad lectora, rendimiento en matemáticas, aprendizaje de idiomas… De todo. Ante esta evidencia, es tentador pensar que entrenando la MT se podría desarrollar cualquier capacidad cognitiva. Si esto fuera cierto, el rendimiento intelectual podría mejorarse fácilmente mediante sencillos juegos de ordenador que nos obligaran a ejercitar la MT. Y, en efecto, decenas de estudios parecen (o parecían) sugerir que estos programas de entrenamiento funcionan. Sin embargo, un artículo recién publicado por Monica Melby-Lervåg, Thomas Redick y Charles Hulme desafía esta conclusión.

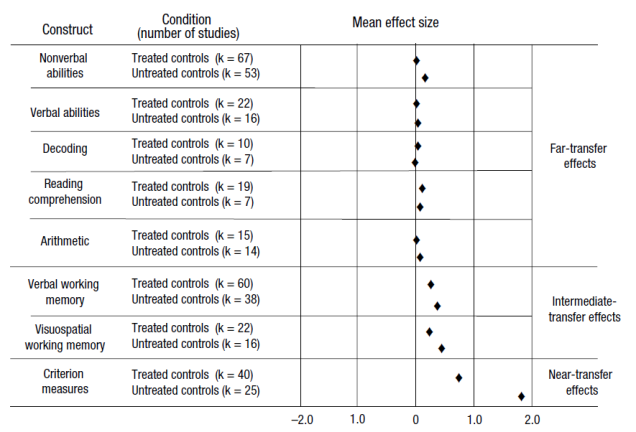

El artículo presenta un meta-análisis de 145 comparaciones experimentales publicadas en 87 artículos. Los resultados pueden resumirse en la figura que reproduzco bajo estas líneas. La columna de la derecha diferencia tres tipos de estudios, dependiendo de si se comprueba el efecto del entrenamiento en habilidades similares a las entrenadas (near-transfer effects), parcialmente similares a las entrenadas (intermediate-transfer effects) o totalmente diferentes a las entrenadas (far-transfer effects). Un primer patrón que puede observarse es que los efectos sólo son grandes en las dos primeras categorías. Entre los estudios que exploran el efecto del entrenamiento sobre habilidades lejanas, los efectos son siempre cercanos a cero.

La figura también clasifica los estudios en función de si utilizan un grupo de control “no tratado” o un grupo de control “tratado”. Los primeros son estudios donde los participantes del grupo de control no realizan ninguna actividad mientras los participantes del grupo experimental reciben el tratamiento. Como puede verse en la figura, los estudios que utilizan este tipo de grupo control pasivo son los que arrojan resultados más prometedores. Por desgracia, este tipo de grupo de control deja mucho que desear. Sería como comprobar la eficacia de una medicina utilizando como control a un grupo de personas que no consume ningún medicamento alternativo, ni siquiera un placebo.

El resultado más interesante del artículo, a mi juicio, es el análisis de la distribución de valores-p. En cualquier área de investigación “sana”, donde se exploran efectos reales, la distribución de valores-p suele mostrar asimetría a la derecha. Esto es, hay muchos más estudios con valores-p entre 0.00 y 0.01 que entre 0.04 y 0.05. La gráfica 3 del artículo, que reproduzco a la izquierda, muestra justo el patrón contrario entre los estudios que utilizaron controles “tratados”. Este tipo de distribución plana -o incluso con asimetría a la izquierda- es el que suele observarse en presencia de falsos positivos. De hecho, aunque los autores son demasiado benévolos para discutir esta posibilidad, la asimetría a la izquierda sugiere que estos estudios podrían estar sesgados por cierta dosis de p-hacking. Es decir, que los datos podrían haberse analizado una y otra vez de diversas maneras hasta que, por azar, se obtuvieron resultados significativos.

El resultado más interesante del artículo, a mi juicio, es el análisis de la distribución de valores-p. En cualquier área de investigación “sana”, donde se exploran efectos reales, la distribución de valores-p suele mostrar asimetría a la derecha. Esto es, hay muchos más estudios con valores-p entre 0.00 y 0.01 que entre 0.04 y 0.05. La gráfica 3 del artículo, que reproduzco a la izquierda, muestra justo el patrón contrario entre los estudios que utilizaron controles “tratados”. Este tipo de distribución plana -o incluso con asimetría a la izquierda- es el que suele observarse en presencia de falsos positivos. De hecho, aunque los autores son demasiado benévolos para discutir esta posibilidad, la asimetría a la izquierda sugiere que estos estudios podrían estar sesgados por cierta dosis de p-hacking. Es decir, que los datos podrían haberse analizado una y otra vez de diversas maneras hasta que, por azar, se obtuvieron resultados significativos.

Estos resultados revisten una especial importancia para el diseño de intervenciones educativas para niños con problemas de aprendizaje. Entre algunos profesionales comenzaba a cuajar la idea de que estos problemas podían paliarse mediante el entrenamiento de la MT. Los resultados de este meta-análisis sugieren que este tipo de prácticas están seguramente avocadas al fracaso.

__________

Melby-Lervag, M., Redick, T. S., & Hulme, C. (2016). Working memory training does not improve performance on measures of intelligence or other measures of “far transfer”: Evidence from a meta-analytic review. Perspectives on Psychological Science, 11, 512-534.

Poniendo en contexto la replicabilidad de la psicología

Desde que se publicaron los resultados del Reproducibility Project: Psychology (RPP) las actitudes de la comunidad científica se han dividido entre quienes creen que es necesario cambiar radicalmente la forma en la que se hace investigación en nuestra disciplina y quienes consideran que la situación no es tan mala y que los métodos que se han venido utilizando hasta ahora han funcionado razonablemente bien. A falta de términos mejores –y ya que estamos en plena campaña electoral– llamaré a los primeros reformistas y a los segundos conservadores.

Uno de los argumentos más frecuentemente esgrimidos por los conservadores es que el fracaso a la hora de replicar un fenómeno no quiere decir necesariamente que ese fenómeno no exista. Si acaso, una réplica fallida revela que ese fenómeno sólo aparece en circunstancias muy concretas y que, tan pronto como se cambia algo en un estudio, el efecto desaparece. Por ejemplo, si hacemos un estudio sobre las actitudes de los blancos hacia las personas de otras razas, es muy probable que los resultados sean muy diferentes en países como EE.UU. que en Holanda o Australia. Si alguien no consigue replicar en Holanda un resultado que se observó inicialmente en EE.UU. esto no quiere decir que el hallazgo original fuera falso sino, simplemente, que sólo puede detectarse en circunstancias muy concretas.

Un trabajo recién publicado en la prestigiosa PNAS sugiere que los resultados negativos del RPP podrían deberse en buena parte a las dificultades para recrear el contexto de los experimentos originales. Los autores de este estudio pidieron a tres investigadores que leyeran los abstracts de los 100 estudios que se habían intentado replicar en el RPP y que, en base únicamente a esos textos, juzgaran hasta qué punto los fenómenos estudiados podrían depender del contexto en el que tenía lugar el estudio. Por ejemplo, se les pedía que estimaran si los resultados podrían depender de que el estudio se realizara en un momento concreto (por ejemplo, tiempos de recesión), en una comunidad étnica, racial o cultural concreta (por ejemplo, mezcla de diferentes razas, culturas individualistas), o en un entorno rural o urbano, entre otros aspectos.

Los autores del estudio tomaron estas estimaciones de la importancia del contexto y analizaron hasta qué punto ayudaban a predecir si un experimento se replicaría o no. Los resultados más importantes se muestran en la figura adjunta. Lo que aquí se muestra es que, después de controlar estadísticamente algunas de las variables más importantes (por ejemplo, la potencia estadística de la réplica, la “sorpresividad” del efecto en cuestión), la sensibilidad al contexto seguía explicando una parte importante de la varianza. Estos datos vienen a confirmar que manteniendo constantes todos los demás factores, algunos fenómenos son más sensibles al contexto que otros y esa mayor sensibilidad determina que puedan ser fácilmente replicados o no.

Los autores del estudio tomaron estas estimaciones de la importancia del contexto y analizaron hasta qué punto ayudaban a predecir si un experimento se replicaría o no. Los resultados más importantes se muestran en la figura adjunta. Lo que aquí se muestra es que, después de controlar estadísticamente algunas de las variables más importantes (por ejemplo, la potencia estadística de la réplica, la “sorpresividad” del efecto en cuestión), la sensibilidad al contexto seguía explicando una parte importante de la varianza. Estos datos vienen a confirmar que manteniendo constantes todos los demás factores, algunos fenómenos son más sensibles al contexto que otros y esa mayor sensibilidad determina que puedan ser fácilmente replicados o no.

No es ningún secreto que mis simpatías se decantan hacia el lado de los reformistas. Aunque valoro este tipo de trabajos y puedo apreciar su contribución, inevitablemente me despiertan sospechas. Ya he contestado aquí a quienes argumentan que los intentos fallidos de replicar un experimento se deben atribuir a moderadores y variables contextuales. Mi argumentación es idéntica en este caso. Puedo entender que unos fenómenos sean más delicados que otros y que requieran un mayor esfuerzo por parte del investigador para recrear las condiciones ideales; pero este argumento deja sin explicar la clara evidencia de sesgos de publicación y de p-hacking en los estudios originales del RPP. Uno de las gráficas que mejor lo demuestra es esta distribución de valores z elaborada por Richard Kunert. Un experimento tiene resultados significativos cuando su z es mayor de 1.96. Como puede verse en este gráfico, las puntuaciones z de los estudios originales del RPP es extremadamente irregular, con un pico muy pronunciado justo alrededor de 2. Esta distribución sugiere que ha habido sesgos de publicación (los estudios con z < 1.96 se han borrado del mapa) o malas prácticas (los estudios con z < 1.96 se han reanalizado una y otra vez hasta que por arte de magia se ha obtenido una z > 1.96). Nada de esto quiere decir que los autores del estudio en PNAS se equivoquen. Pero sospecho que representa sólo una parte de la historia. Una parte que puede resultar reconfortante, pero que tal vez nos ayude poco a mejorar la ciencia que hacemos.

No es ningún secreto que mis simpatías se decantan hacia el lado de los reformistas. Aunque valoro este tipo de trabajos y puedo apreciar su contribución, inevitablemente me despiertan sospechas. Ya he contestado aquí a quienes argumentan que los intentos fallidos de replicar un experimento se deben atribuir a moderadores y variables contextuales. Mi argumentación es idéntica en este caso. Puedo entender que unos fenómenos sean más delicados que otros y que requieran un mayor esfuerzo por parte del investigador para recrear las condiciones ideales; pero este argumento deja sin explicar la clara evidencia de sesgos de publicación y de p-hacking en los estudios originales del RPP. Uno de las gráficas que mejor lo demuestra es esta distribución de valores z elaborada por Richard Kunert. Un experimento tiene resultados significativos cuando su z es mayor de 1.96. Como puede verse en este gráfico, las puntuaciones z de los estudios originales del RPP es extremadamente irregular, con un pico muy pronunciado justo alrededor de 2. Esta distribución sugiere que ha habido sesgos de publicación (los estudios con z < 1.96 se han borrado del mapa) o malas prácticas (los estudios con z < 1.96 se han reanalizado una y otra vez hasta que por arte de magia se ha obtenido una z > 1.96). Nada de esto quiere decir que los autores del estudio en PNAS se equivoquen. Pero sospecho que representa sólo una parte de la historia. Una parte que puede resultar reconfortante, pero que tal vez nos ayude poco a mejorar la ciencia que hacemos.

__________

Van Bavel, J. J., Mende-Siedlecki, P., Brady, W. J., & Reinero, D. A. (2016). Contextual sensitivity in scientific reproducibility. Proceedings of the National Academy of Sciences of the United States of America, 113, 6454-6459.

Cómo (no) saber si un proceso mental es inconsciente: El caso del aprendizaje implícito

Las técnicas estadísticas que utilizamos habitualmente en los experimentos de psicología están pensadas para evitar caer en el error de ver una pauta donde sólo hay ruido y azar. Precisamente por eso, estas técnicas no deben utilizarse cuando lo que queremos hacer es demostrar que los datos se deben al azar. A pesar de ello, hay grandes áreas de investigación donde se cae en este error de forma rutinaria. Un ejemplo fascinante es la investigación sobre aprendizaje implícito (o inconsciente). Según un meta-análisis reciente, buena parte de lo que creemos saber sobre el aprendizaje inconsciente podría estar sesgado por este sencillo error. Continúa leyendo en Ciencia Cognitiva…

La psicología al desnudo

Ayer por la noche, la prestigiosa revista Science publicaba bajo el título “Estimating the reproducibility of psychological science” los resultados del que sin duda será el estudio del año o de la década. Doscientos setenta investigadores de todo el mundo se pusieron de acuerdo para intentar replicar cien experimentos de psicología publicados originalmente en 2008 en tres de las más importantes revistas de psicología: Journal of Experimental Psychology: Learning, Memory and Cognition; Journal of Personality and Social Psychology; y Psychological Science. Tal y como reconocen los propios autores, no hay una única forma de estimar si un estudio ha replicado exitosamente los resultados de otro. Pero si tomamos como medida del éxito el simple hecho de si la réplica ha arrojado resultados estadísticamente significativos o no, entonces tan sólo el 36% de los estudios originales se ha replicado. El artículo y su abundante material suplementario están llenos de matices e información valiosa que habrá que desmenuzar y analizar con calma durante los próximos días. Pero aquí quiero quedarme únicamente con esa cifra aparentemente penosa: 36%.

Apenas publicado el artículo, los titulares de medio mundo se llenaban con la triste noticia de que sólo el 36% de los experimentos de psicología eran replicables. Pero, ¿es poco un 36%? Si te paras a pensarlo, esta pregunta es más difícil de responder de lo que parece. Sin duda, un 36% es mucho menos de lo que esperábamos y de lo que creemos deseable para cualquier ciencia sana. Pero si la pregunta se enfoca bajo otro ángulo y nos preguntamos si un 36% es una cifra normal o no para una disciplina científica, enseguida caeremos en la cuenta de que no tenemos absolutamente ninguna evidencia para responder a esta pregunta. Son varios los estudios de carácter estadístico que han sugerido que los datos publicados en las revistas son demasiado bonitos para ser cierto y que seguramente en torno al 50% o más de los resultados científicos son falsos positivos. Pero en su mayor parte estas estimaciones son sólo elucubraciones teóricas basadas en la estadística. Más allá de la especulación lo cierto es que, salvo por unos pocos estudios pequeños y poco sistemáticos, apenas tenemos datos empíricos sobre cómo de replicables son los resultados que se publican en las revistas científicas. De cualquier disciplina.

Durante una temporada, los blogs, periódicos y revistas se harán eco del titular fácil de que sólo uno de cada tres experimentos de psicología puede replicarse. Sin embargo, creo que no pasará mucho tiempo hasta que se le reconozca a la psicología el mérito de haber sido la primera disciplina en mostrar sus vergüenzas y reconocer que el rey va ligero de ropa. El artículo recién publicado en Science es el primer intento serio de explorar a gran escala la replicabilidad de los resultados científicos. Espero que le sigan muchos, dentro de la propia psicología y también en otras disciplinas, como el ya iniciado Cancer Biology Reproducibility Project. Preveo que pasado el tiempo, el artículo de estos 270 investigadores no será motivo de vergüenza para los psicólogos experimentales, sino que permanecerá como recordatorio de que un día esta pequeña disciplina se puso al frente de un movimiento llamado a revolucionar la ciencia que practicamos.

__________

Open Science Collaboration (2015). Estimating the reproducibility of psychological science. Science, 349, aac4716.

Should physicians think “unconsciously”?

It has become almost impossible to open a popular psychology book without coming across one or several chapters about the role of intuition and unconscious processes in decision making. If you haven’t heard about the “fast” System 1, “gut feelings” or decisions made in a “blink”, it might be difficult to beat your friends next time you play a trivia game. A common topic of this literature is that many of our daily decisions are based on automatic cognitive processes that we can hardly control and that remain out of consciousness. Some authors go one step further and suggest that, in fact, unconscious processes usually outperform deliberate thinking. Perhaps you have already heard that you should rely on your “gut feeling” when making complex financial decisions, like how to invest your savings. What you probably didn’t know is that some scholars are also starting to advise physicians to rely on their intuition to make better diagnoses. Read the post in Mapping Ignorance.

Si tu médico te dice que “piensa inconscientemente”…

Uno de los pecados más habituales de los divulgadores científicos es lanzarnos a colgar en nuestros blogs comentarios de los estudios más sexys que se publican sin pararnos a pensar si esos resultados serán sólidos o no. Desde luego, no merezco ser yo quien tire la primera piedra contra nadie. Si alguna vez he caído en ese error, y seguro que así ha sido, espero que el último artículo que acabo de publicar en Frontiers in Psychology con Olga Kostopoulou y David Shanks me redima de mis excesos.

Entre los hallazgos más intrigantes que se han publicado en los diez últimos años brilla con luz propia el llamado efecto de pensamiento inconsciente. Un estudio publicado en Science en 2006 sugería que cuando las personas nos vemos obligadas a tomar una decisión particularmente difícil, como elegir el mejor coche de un catálogo o decidir entre varios apartamentos, puede ser mejor dejar pasar un periodo de tiempo distraídas en otros asuntos que dedicar el mismo tiempo a pensar en el problema en cuestión. Este descubriendo encaja bastante bien con el actual interés por todo lo que tiene que ver con la intuición y los heurísticos. De hecho, es muy difícil abrir un libro de divulgación sin encontrarse referencias a estos famosos experimentos.

¿Demasiado bonito para ser cierto? Posiblemente sí. Muchos de los experimentos que han intentado replicar este efecto han fracasado estrepitosamente. Y se han publicado al menos dos meta-análisis que sugieren que en los contados casos en los que se ha encontrado este fenómeno, podría no ser más que un falso positivo. A pesar de estas críticas, el entusiasmo por el pensamiento inconsciente no ha perdido un ápice de intensidad en los últimos años.

Tal vez te preocupe saber que, entre las muchas cosas para las que se ha sugerido que el pensamiento inconsciente podría ser útil, figura la toma de decisiones médicas. Como lo oyes. Según este punto de vista, cuando un médico tiene que decidir cuál es tu diagnóstico o cómo de grave es tu enfermedad, lo mejor que puede hacer es delegar la decisión en su “inconsciente”, especialmente si tu caso es complejo. Y, lo creas o no, hasta hace poco esta recomendación tenía cierto apoyo empírico. En 2010 se publicó un estudio en el que se observó que los estudiantes de psicología clínica hacían mejores diagnósticos después de un periodo de distracción que después de un periodo de reflexión equivalente. No es de extrañar que empezaran a publicarse artículos en revistas médicas sugiriendo que la carrera de medicina debía incluir asignaturas para educar la “intuición médica”.

Lo que estos artículos no mencionan es que ha habido al menos otros tres intentos de replicar el efecto de pensamiento inconsciente en toma de decisiones médicas y que ninguno de ellos ha tenido resultados positivos. Y no parece que estos resultados nulos se deban a falta de potencia estadística. Según el meta-análisis que acabamos de publicar, si uno toma en conjunto todos estos estudios sobre decisiones médicas, el efecto de pensamiento inconsciente no es estadísticamente significativo. De hecho, aplicando una sencilla técnica estadística conocida como Bayes Factor hemos podido comprobar que la mayor parte de los estudios realizados dan apoyo a la idea de que el efecto de pensamiento inconsciente no ha tenido lugar.

De modo que, para terminar la frase que abre este post, si tu médico te dice que toma sus decisiones basándose en la intuición, dile que lea esta entrada dos veces cuando baje la marea. Y, sí, cambia de médico.

__________

Vadillo, M. A., Kostopoulou, O., & Shanks, D. R. (2015). A critical review and meta-analysis of the unconscious thought effect in medical decision making. Frontiers in Psychology, 6, 636.

Bilingüismo y sus ventajas: ¿Exageración científica?

Se me ocurren muchas razones por las que merece la pena estudiar un nuevo idioma. Pero a juzgar por las conclusiones del artículo recién publicado por de Bruin, Treccani, y Della Sala (2015) en Psychological Science, tal vez deba tachar alguna de ellas de mi lista o al menos moverla más abajo. Durante los últimos años se ha hecho fuerte la idea de que el bilingüismo es una suerte de gimnasia mental que mejora diversas capacidades cognitivas, especialmente aquellas a las que se alude genéricamente con el nombre de control ejecutivo. Apenas puede uno abrir un volumen de cualquier revista de psicología sin encontrarse un artículo sobre el tema. Como no podría ser de otra forma, la idea se ha abierto camino rápidamente en la cultura popular y muy especialmente en el mundo de la educación. Los medios de comunicación también se han hecho eco de esta idea, con, por ejemplo, “¿Por qué los bilingües son más inteligentes?” (La Vanguardia, 2012), “El bilingüísmo mejora la atención” (El País, 2007) o “El bilingüismo protege el cerebro” (El Mundo, 2014). Continúa leyendo en Rasgo Latente…

¿Quién es feliz en Londres?

No, no se asusten. No me ha dado un ataque de melancolía. Mamá, estoy bien. Casualmente acabo de encontrarme con un artículo recién publicado en PNAS cuyos autores utilizan la ciudad de Londres más o menos como los biólogos usan esos terrarios gigantes para estudiar el comportamiento de hormigas, termitas y bichos dispares. Cualquiera que haya tenido que salir de su barrio alguna vez en la vida se habrá percatado de que cada zona geográfica tiene un carácter diferente, marcado por la personalidad de quienes viven allí, su nivel socioeconómico y hasta la geología y el clima del lugar. Lógicamente algunos de estos lugares se ajustan más a nuestras peculiaridades que otros, y no es extraño que cada uno de nosotros aspire a vivir en determinado lugar para ser más feliz. ¿Pero exactamente cómo se relacionan nuestra personalidad, el carácter del lugar que habitamos y la felicidad? Qué mejor lugar para responder a esta pregunta que Londres, donde en un puñado de kilómetros cuadrados conviven las personas más diversas en los barrios más heterogéneos. Apenas unos metros separan el bullicioso mercado de Camden del sosegado Hampstead. Y en cualquier local de comida rápida se puede ver compartir mesa a los más despiadados ejecutivos de la City con los futuros reclutas del estado islámico.

El estudio que firman Markus Jokela y colaboradores se basa en una metodología sencilla pero ingeniosa. Pidieron a nada menos que 52.000 vecinos del área metropolitana de Londres que rellenaran un cuestionario diseñado para medir los cinco factores de personalidad (los famosos Big Five: apertura a la experiencia, responsabilidad, extroversión, amabilidad y neuroticismo) y otro pequeño cuestionario para medir la satisfacción con la vida en general. Dentro de cada distrito postal hicieron una regresión múltiple para predecir la satisfacción vital a partir de las puntuaciones en los cinco factores de personalidad. Como te puedes imaginar, los resultados de estas regresiones no fueron idénticos en todos los distritos: algunas características de personalidad resultaron ser buenas predictoras de la satisfacción en todos los distritos, pero otras características correlacionaban con la satisfacción sólo en algunos lugares. La pregunta que los autores se hicieron es ¿qué aspectos de un distrito hacen que un factor de personalidad contribuya más o menos a la felicidad de sus habitantes?

Los resultados muestran que hay dos factores de personalidad que correlacionan con la felicidad de forma generalizada, independientemente del lugar en que uno viva. Se trata de los factores extroversión y neuroticismo. Las personas extrovertidas y emocionalmente estables tienden a ser más felices y más o menos en el mismo grado en cualquier lugar de Londres. Sin embargo, el resto de factores contribuye más o menos a tu felicidad según dónde vivas. Si vives en el centro de Londres, rodeado de personas de todas las nacionalidades y de las gastronomías más atrevidas (aunque en Londres todas lo son, en un sentido u otro), tu felicidad dependerá en buena medida de si eres una persona abierta a la experiencia o no. Interesante, pero ninguna sorpresa hasta aquí: Básicamente, las personas abiertas a la experiencia son más felices donde viven otras personas abiertas a la experiencia. Lo interesante es que los otros dos factores de personalidad no funcionan de esta manera. La amabilidad y la responsabilidad son buenos predictores de la felicidad en los barrios en los que la felicidad escasea y las condiciones de vida son menos favorables. De hecho, la responsabilidad correlaciona con la felicidad (y esto es lo interesante) en los distritos donde la gente tiende a puntuar bajo en responsabilidad. O, en otras palabras, en el país de los ciegos el tuerto es el rey.

Según los autores, estos resultados confirman las predicciones de un modelo en el que algunos factores de personalidad (como la extroversión y el neuroticismo) están asociados directamente con la felicidad, mientras que otros factores (como la responsabilidad y la amabilidad) están asociados con la felicidad por su valor instrumental. Es decir, mientras que la extroversión y el neuroticismo son en sí mismas fuentes de felicidad, la responsabilidad y la amabilidad son útiles como medio para conseguir otras cosas que son a su vez fuente de felicidad. El grado en que estas “habilidades” son necesarias depende en gran medida de las condiciones más o menos favorables en las que nos haya tocado vivir, lo que explicaría que su contribución neta a la felicidad dependa de las circunstancias.

Una de las principales limitaciones del estudio es que nos dice poco o nada sobre qué hace felices a las personas en otros barrios de Bilbao. Pero, en fin, nadie es perfecto.

__________

Jokela, M., Bleidorn, W., Lamb, M. E., Gosling, S. D., & Rentfrow, P. J. (2015). Geographically varying associations between personality and life satisfaction in the London metropolitan area. Proceedings of the National Academy of Sciences, 112, 725-730.

El fabuloso método Doman

Debió ser Chesterton quien dijo que lo malo de que las personas dejen de creer en Dios no es que dejen de creer en todo, sino que empiecen a creer en cualquier cosa. No se me ocurre una analogía mejor para entender los cambios más recientes en el mundo de la educación. Casi todo el mundo está de acuerdo en que la escuela tiene que cambiar. En el siglo XXI ya no nos vale aquello de aprender la lista de los reyes godos y afortunadamente también podemos darle carpetazo a la “formación político-social para niños” y a la “higiene para niñas”. Queremos algo mejor para las generaciones que nos sigan. Pero ahí es donde termina el acuerdo. Tan pronto como nos ponemos a discutir cómo debería ser la nueva educación, el consenso desaparece. O peor aún, el vacío que deja la educación tradicional se llena con todo tipo de ideas felices que son abiertamente peores que lo que hacíamos.

Entre las modas pseudocientíficas más pintorescas que pueblan el panorama escolar del siglo XXI, una de las que más me preocupan es el movimiento educativo liderado por Glenn Doman. Desconozco el impacto de sus ideas fuera de mi entorno más cercano. Pero al menos en el País Vasco no es exagerado decir que los libros de Doman se han convertido en una nueva Biblia. Si el lector tiene hijos o sobrinos en educación infantil, es muy probable que las técnicas que voy a describir más abajo se hayan usado con ellos. El manual de referencia para entender estas prácticas es el best-seller Cómo multiplicar la inteligencia de su bebé. En este libro (y en sus numerosas precuelas y secuelas) Glenn Doman describe un método sencillo y prodigioso para enseñar habilidades lectoras y matemáticas a niños de tan sólo meses de edad. Según dice el autor, se basa “en muchos años de trabajo por parte de un gran equipo de expertos en el desarrollo del cerebro infantil, que habían estudiado el desarrollo y funcionamiento del cerebro humano” (p. 169).

Entre las modas pseudocientíficas más pintorescas que pueblan el panorama escolar del siglo XXI, una de las que más me preocupan es el movimiento educativo liderado por Glenn Doman. Desconozco el impacto de sus ideas fuera de mi entorno más cercano. Pero al menos en el País Vasco no es exagerado decir que los libros de Doman se han convertido en una nueva Biblia. Si el lector tiene hijos o sobrinos en educación infantil, es muy probable que las técnicas que voy a describir más abajo se hayan usado con ellos. El manual de referencia para entender estas prácticas es el best-seller Cómo multiplicar la inteligencia de su bebé. En este libro (y en sus numerosas precuelas y secuelas) Glenn Doman describe un método sencillo y prodigioso para enseñar habilidades lectoras y matemáticas a niños de tan sólo meses de edad. Según dice el autor, se basa “en muchos años de trabajo por parte de un gran equipo de expertos en el desarrollo del cerebro infantil, que habían estudiado el desarrollo y funcionamiento del cerebro humano” (p. 169).

Sin entrar aún en detalles sobre las técnicas concretas, resulta interesante contemplar las creencias que albergan estos “expertos”. Si habías oído hablar del mito de que sólo usamos el 10% del cerebro y querías más, estás de enhorabuena, porque en este libro encontrarás el mito del 1 por 1000. En palabras del autor, “no es cierto que sólo utilicemos una décima parte de nuestro cerebro. No vivimos lo suficiente para utilizar una milésima parte de la capacidad de nuestro cerebro. Es posible que Leonardo da Vinci llegase a usar casi una milésima parte de la capacidad de su cerebro: Por eso fue Leonardo da Vinci” (p. 112). Al parecer la capacidad del cerebro es de 125.500.000.000 unidades de información. Es imposible saber de dónde procede esa cifra porque, como cualquier buena obra de ficción, el libro no contiene ninguna referencia. Cuando Glenn Doman escribió esto le debió parecer una cifra inmensa, pero seguramente estás leyendo este texto desde un ordenador cuyo disco duro hace palidecer esta cifra. Y dudo que calificaras a tu ordenador de inteligente. Pero, en fin, volvamos a lo nuestro. La cuestión es que el cerebro humano tiene una capacidad de almacenamiento pasmosa que según Glenn Doman debemos al hecho de que “sólo los seres humanos tenemos corteza cerebral” (p. 115). Interesante afirmación, viniendo de un grupo de “expertos” neurocientíficos.

Sigamos. Si la capacidad de nuestro cerebro es tan grande, ¿por qué no alcanzamos todas las personas el grado de “genios”? Acertaste: La culpa la tiene la educación que recibimos, que es muy mala e ignora datos básicos sobre nuestra capacidad de aprendizaje. Una primera cosa que ignoran nuestros maestros es que sólo somos capaces de aprender hasta los seis años de edad. “Todo desarrollo significativo del cerebro ha terminado a los seis años de edad” (p. 111). “Los niños podrían estar aprendiendo en sus seis primeros años de vida tres veces más de lo que aprenderán el resto de sus vidas”. A lo mejor te preguntas de dónde vienen estas cifras (6 años, aprender 3 veces más que en el resto de sus vidas…). Te invito a que consultes las referencias inexistentes. Posiblemente se venden por separado, como las pilas que iluminan la espada de He-man.

Otra razón por la que nos han enseñado mal en la escuela es que casi todos los materiales docentes suelen escribirse con letras pequeñas. Pero el sistema visual de los niños aún no está lo suficientemente maduro como para procesar esos estímulos. Los niños sólo entienden materiales escritos (o imágenes impresas) si se presentan en formato “grande, claro y repetido” (p. 79). A juzgar por la insistencia del libro, debe ser crucial no subestimar la importancia de este punto.

Si uno entiende estos sencillos principios sobre el aprendizaje, “tratará a su hijo en esos seis años de una forma totalmente diferente a como lo haría sin comprender estos principios” (p. 88). Y logrará así resultados espectaculares. Como bien sabe el lector, el cociente intelectual medio de un adulto es 100. Pero siguiendo paso a paso los consejos de Doman es posible lograr que nuestro hijo alcance cualquier nivel de inteligencia. “Si usted lee este libro y lo entiende de verdad, y trata a su hijo de manera completamente diferente durante estos seis años fundamentales de vida… entonces debería alcanzar la capacidad propia de los seis años a los tres años de edad cronológica como máximo, y entonces tendría un CI de 200 o de más” (p. 88). Claro que no queda muy claro que significa el concepto de CI en palabras de Doman porque “las pruebas de inteligencia no miden la inteligencia” (p. 91). Para Doman, el CI debe ser una capacidad cuantificable, porque no cesa de decirle a los padres qué CI alcanzarán sus hijos. Pero no puede medirse. Interesante…

Sea como fuere, una vez superadas estas lecciones sobre neurociencia y cognición, el libro continúa explicando detalladamente qué técnicas utilizar para enseñar a los niños a leer, realizar operaciones matemáticas y adquirir conocimientos enciclopédicos. Llegado a este momento tal vez estés esperando que ahora continúe describiéndote las tecnologías neuro-something más sofisticadas. Pero lo cierto es que para conseguir que tu hijo tenga un CI de 200 sólo necesitas cartulina, tijeras y rotulador. Imagina que quieres que tu hijo de 3 meses aprenda a leer la palabra “payaso”. Pues bien, sólo tienes que preparar una lámina como la que te muestro a la izquierda y presentársela brevemente a tu hijo mientas le dices en voz alta “Aquí pone payaso”. Lo más importante es que no te equivoques con las medidas y que pongas el texto en rojo porque “los niños pequeños tienen unas vías visuales inmaduras” (p. 173). También es fundamental que no le presentes las mismas láminas a tu hijo muchos días porque se aburrirá. “No aburra nunca a su hijo. Es mucho más fácil que se aburra por ir despacio que por ir demasiado deprisa”. Así que sólo hay que presentar unas pocas de estas láminas por día y siempre muy brevemente: “no se la deje ver más de un segundo” (p. 176).

Sea como fuere, una vez superadas estas lecciones sobre neurociencia y cognición, el libro continúa explicando detalladamente qué técnicas utilizar para enseñar a los niños a leer, realizar operaciones matemáticas y adquirir conocimientos enciclopédicos. Llegado a este momento tal vez estés esperando que ahora continúe describiéndote las tecnologías neuro-something más sofisticadas. Pero lo cierto es que para conseguir que tu hijo tenga un CI de 200 sólo necesitas cartulina, tijeras y rotulador. Imagina que quieres que tu hijo de 3 meses aprenda a leer la palabra “payaso”. Pues bien, sólo tienes que preparar una lámina como la que te muestro a la izquierda y presentársela brevemente a tu hijo mientas le dices en voz alta “Aquí pone payaso”. Lo más importante es que no te equivoques con las medidas y que pongas el texto en rojo porque “los niños pequeños tienen unas vías visuales inmaduras” (p. 173). También es fundamental que no le presentes las mismas láminas a tu hijo muchos días porque se aburrirá. “No aburra nunca a su hijo. Es mucho más fácil que se aburra por ir despacio que por ir demasiado deprisa”. Así que sólo hay que presentar unas pocas de estas láminas por día y siempre muy brevemente: “no se la deje ver más de un segundo” (p. 176).

El libro prosigue ampliando el mismo método para enseñar matemáticas y conocimientos generales. Sin entrar en detalles, la idea es tan sencilla como presentar una cartulina con, por ejemplo, 15 puntos y decirle al niño “15”. O bien presentar un dibujo de dos puntos seguidos de un “x”, seguido de tres puntos, seguidos de un “=” seguido de seis puntos. Así sucesivamente ¿hasta cuándo? Hasta donde quieras. “Un día, cuando se dispone alegremente a enseñar a su hijo cálculo infinitesimal o física nuclear, se da cuenta de lo que está haciendo y su propio arrojo la sorprende” (p. 228). No creas que para llegar a estos niveles es necesario esperar a que el niño sea muy mayor. En realidad se puede empezar en cualquier momento, siempre que no hayan pasado los seis primeros años, tras los cuales el niño estará condenado irremediablemente a la mediocridad. “Usted puede empezar el proceso de enseñar a su bebé desde el mismo nacimiento”.

Si yo fuera el padre de una criatura con la que fueran a utilizar estos métodos revolucionarios, lo primero que les preguntaría a los profesores es que me enseñaran la evidencia que muestra que estas estrategias sirven para algo. En el libro de Doman no podemos encontrar nada que sugiera que estos métodos se basan en ninguna evidencia seria. Por supuesto, Doman alude constantemente a su experiencia personal como prueba de la eficacia de sus métodos. El equivalente profesional del “a mí me funciona”. Al ciudadano de a pie tal vez esto le sirva para dormir tranquilo creyendo que su hijo está aprendiendo a leer con los mejores métodos. Pero tal vez convenga recordarle que a lo largo de la historia miles de niños y adultos han muerto por las sangrías y otras técnicas milagrosas que los médicos han estado utilizando hasta hace pocas décadas amparados en su experiencia personal. La eficacia de cualquier técnica, da igual que sea médica o docente, tiene que evaluarse mediante estudios controlados bien diseñados y con grandes muestras. El libro de Doman no nos ofrece nada parecido a esa evidencia. No sé si he dicho ya que el libro no tiene ninguna referencia que nos dirija a los estudios que avalan la eficacia de estas técnicas o la veracidad de cualquiera de sus afirmaciones. He pasado horas buceando en la Web of Science en busca de cualquier estudio que haya puesto a prueba la eficacia del método Doman y no he encontrado absolutamente nada. Si existen, deben ser los estudios mejor escondidos de la historia de la ciencia.

Pero la historia no termina aquí. El problema del método Doman no es sólo que no tenemos razones para pensar que funciona, sino que, de hecho, hay muchas razones para pensar que pueda ser perjudicial. Por ejemplo, en el caso de la enseñanza de la lectura, Doman insiste continuamente en que es crucial centrarse en enseñarle al niño a entender palabras completas y no el significado de cada una de las letras. En otras palabras, no hay que enseñar explícitamente que cada letra representa un sonido. “Las letras del abecedario no son las unidades de la lectura y de la escritura, como los sonidos aislados tampoco son las unidades de la audición ni del habla” (p. 179). A diferencia de muchas de las citas que he seleccionado más arriba, puede que al lector ésta no le parezca especialmente sospechosa. Al fin y al cabo, en muchos colegios se está poniendo de moda enseñar a los niños a leer palabras completas antes de enseñarles el abecedario o la mera idea de que las letras representan sonidos. Sin embargo, es difícil exagerar lo dañina que es esta práctica. En el mundo de la educación son pocas las cosas que se saben a ciencia cierta, pero los datos de que disponemos dejan poco lugar a dudas de que este método de enseñanza es peor que el método tradicional en el que al niño se le enseña explícitamente qué fonemas representa cada letra. Sí, aquello de la b con la a “ba”. Que multitud de escuelas se apunten a la moda de no enseñar estas sencillas reglas tal vez no sea un problema para el 80-90% de los niños que aprenderán a leer sin ninguna dificultad independientemente del método que se utilice. Pero si tu hijo o sobrino es de los que por desgracia caen fuera de esta afortunada mayoría, la probabilidad de que tenga dificultades de lectura aumenta notablemente si no ha sido educado con un buen método.

En cualquier caso, lo más preocupante del auge de este tipo de métodos milagro no es si esta o aquella técnica pueden ser contraproducentes, sino la actitud general de que “todo vale” y que en educación es perfectamente legitimo sustituir las técnicas tradicionales por cualquier sucedáneo que venga en un envoltorio más trendy. Aunque la medicina ha existido durante siglos, sólo ha empezado a paliar el sufrimiento humano y a alargar nuestra esperanza de vida desde finales del siglo XIX. La diferencia fundamental entre la medicina que se practicaba antes de ese momento y la que se practica después es que, tras vencer innumerables resistencias, la comunidad de médicos finalmente aceptó que ningún tratamiento podía considerarse válido sólo porque algunos o muchos “expertos” así lo dijeran. La eficacia de cada tratamiento era algo que había que comprobar empíricamente, tomando todas las cautelas necesarias para no dejarse engañar por las falsas apariencias y los deseos bienintencionados. ¿Se imaginan cómo serían nuestras escuelas si el mundo educativo hubiera decidido seguir este mismo camino?

Cómo medir la calidad de la enseñanza universitaria

Una de las quejas más recurrentes del profesorado universitario es que el sistema académico valora más la investigación que la docencia. Este descontento no afecta sólo a los profesores individuales, sino a las universidades en su conjunto, cuya situación en los rankings de calidad suele depender no tanto de la enseñanza como de su producción científica. Quienes han tenido la desgracia de padecerme durante años saben que tiendo a atribuir estas afirmaciones más a los malos investigadores que a los buenos profesores. Pero no por ello dejo de estar de acuerdo con ellas.

El gran problema de medir la calidad de una universidad por su excelencia docente es que, a diferencia de lo que sucede con la investigación, no tenemos ninguna metodología válida para medirla y no ha habido ningún interés en desarrollarla. Lo más parecido que tenemos son las evaluaciones del profesorado que rellenan los estudiantes al terminar cada asignatura y que muy de vez en cuando tienen algún peso en la contratación de profesores o en su ascenso. ¿Sirven estas evaluaciones para medir la calidad de un profesor? Todo sugiere que no, o al menos eso es lo que se desprende de un estudio reciente de Michaela Braga, Marco Paccagnella y Michele Pellizzari. Este estudio aprovecha que en la universidad de la primera autora existen asignaturas que son impartidas por varios profesores. La asignación de los estudiantes a cada uno de los profesores es totalmente aleatoria. Eso les permite explorar cómo la experiencia de haber recibido clases de un profesor u otro influye en el rendimiento futuro de cada estudiante. La idea es que si un profesor es bueno, los estudiantes que hayan aprendido con él tendrán un mejor rendimiento durante los años siguientes que los estudiantes que no hayan pasado por sus manos.

Los resultados del estudio muestran que, cuando la calidad de un profesor se mide de esta manera, las puntuaciones resultantes correlacionan negativamente con las evaluaciones de satisfacción que hacen los estudiantes al terminar la asignatura. En otras palabras, los profesores que dejan mejor huella en sus alumnos tienden también a dejarlos más insatisfechos. Los datos sugieren que esta correlación negativa se debe sobre todo a los peores estudiantes, ya que no está presente en las aulas donde predominan los buenos estudiantes.

Lo que sí que correlaciona positivamente con las encuestas de satisfacción son las notas que reciben los alumnos. Si un profesor pone buenas notas, entonces los estudiantes le dan una mejor puntuación en las encuestas de satisfacción. Todo sugiere que lo que están midiendo estas encuestas no es la calidad de la docencia, sino simplemente la cantidad de esfuerzo que un profesor les exige a sus alumnos. De hecho, se trata de una medida tan mala, que los autores del estudio han llegado a encontrar una relación entre el tiempo que hace el día en que se rellena la encuesta y los resultados de la misma. Los alumnos dan mejores puntuaciones a sus profesores si hace sol que si llueve.

No sé qué conclusiones puede extraer un alumno de estos datos, pero sí creo que nos permiten darles algunos consejos a los profesores universitarios que quieran aspirar a la excelencia. Primero, intenta que tu asignatura se imparta durante la primavera para que la evaluación coincida con los primeros días del verano. Y segundo, tus evaluaciones serán mucho mejores si en plena clase de Psicología de la Personalidad les pones a tus alumnos dos horas de Buscando a Nemo o en su defecto cualquier película recomendada para niños menores de 4 años.

__________

Braga, M., Paccagnella, M., & Pellizzari, M. (2014). Evaluating students’ evaluations of professors. Economics of Education Review, 41, 71-88.

Producto interior bruto, interés por la ciencia y rendimiento científico

Una de las desgracias de ser español es que cuando se publican los resultados del informe PISA entras en un estado catatónico que te impide reaccionar a cualquier estimulación hasta que la siguiente jornada de liga te resetea y todo vuelve a la normalidad. Afortunadamente los habitantes de otros países son capaces de indagar y rebuscar en los datos de PISA sin que las lágrimas se lo impidan. Gracias a ellos, de vez en cuando descubrimos algunas pautas interesantes, como las que se perfilan en el estudio que acaban de publicar Elliot Tucker-Drob, Amanda Cheung y Daniel Brilley en Psychological Science.

El artículo se centra en la relación entre el interés por la ciencia y el rendimiento de los estudiantes en las pruebas de ciencia de los exámenes PISA. Lógicamente, los estudiantes a los que les interesa más la ciencia suelen puntuar más alto en estas pruebas. Lo interesante es que cómo de estrecha es esa relación depende de un número de factores. Si lo piensas bien, hay muchos obstáculos que pueden hacer que un estudiante con interés por la ciencia no llegue a ser bueno en ciencias. Tucker-Drob y colaboradores nos revelan algunos de ellos.

Uno de los resultados más interesantes es que el grado de relación entre interés por la ciencia y rendimiento científico depende del producto interior bruto (PIB) del país. En general, en los países más ricos, la relación entre interés y rendimiento es más fuerte. Se trata sólo de una correlación (aunque muy fuerte) que podría obedecer a varios motivos. La interpretación más sencilla es que los países más ricos proporcionan más oportunidades para que las personas con interés por ciencia desarrollen sus capacidades. En otras palabras, los países ricos facilitan que el talento se convierta en rendimiento. Aunque es interesante que también cabe la interpretación contraria: Tal vez los países donde las personas con interés por la ciencia pueden perseguir sus intereses acaben siendo más prósperos.

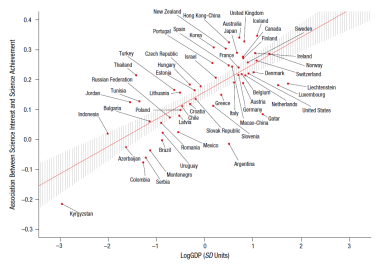

Reproduzco aquí la figura con los datos sobre la relación entre PIB y correlación interés-rendimiento. Cuidado al interpretar esta gráfica: Los países que están más arriba no son necesariamente los que obtienen mejor rendimiento en ciencias, sino aquellos donde la relación entre interés y rendimiento es más fuerte. Por una vez, agrada ver que España está ligeramente por encima del intervalo de confianza para esta regresión. Es decir, la relación entre interés y rendimiento es ligeramente mayor de lo que cabría predecir dado el PIB español. Italia, por ejemplo, tiene un PIB ligeramente superior, pero una correlación interés-rendimiento claramente inferior. Tal vez los datos más positivos sean los de Australia o Reino Unido, países que además de tener un PIB alto presentan una relación interés-rendimiento excepcionalmente alta. Se trata de países especialmente buenos a la hora de hacer que los alumnos más interesados consigan un buen dominio de las ciencias. Es curioso que algunos países muy prósperos, como Luxemburgo, presentan sin embargo correlaciones muy bajas.

Reproduzco aquí la figura con los datos sobre la relación entre PIB y correlación interés-rendimiento. Cuidado al interpretar esta gráfica: Los países que están más arriba no son necesariamente los que obtienen mejor rendimiento en ciencias, sino aquellos donde la relación entre interés y rendimiento es más fuerte. Por una vez, agrada ver que España está ligeramente por encima del intervalo de confianza para esta regresión. Es decir, la relación entre interés y rendimiento es ligeramente mayor de lo que cabría predecir dado el PIB español. Italia, por ejemplo, tiene un PIB ligeramente superior, pero una correlación interés-rendimiento claramente inferior. Tal vez los datos más positivos sean los de Australia o Reino Unido, países que además de tener un PIB alto presentan una relación interés-rendimiento excepcionalmente alta. Se trata de países especialmente buenos a la hora de hacer que los alumnos más interesados consigan un buen dominio de las ciencias. Es curioso que algunos países muy prósperos, como Luxemburgo, presentan sin embargo correlaciones muy bajas.

Otro dato interesante del estudio es que da pistas muy claras sobre cómo influye el estatus socio económico de la familia en la relación entre interés y rendimiento. Como cabría esperar, la ejecución de los niños está más relacionada con sus intereses en las familias de clase alta, que son las que tienen más recursos para hacer que los niños desarrollen sus intereses. Pero, y aquí viene lo bueno, esta relación está totalmente mediada por el estatus socio económico medio de las escuelas en las que estudian sus niños. Es decir, que importa más el estatus de la escuela que el estatus de la familia. O dicho de otra forma, si una familia tiene un niño con interés por la ciencia, merece la pena hacer el esfuerzo de enviar a ese niño a una escuela “por encima de sus posibilidades”.

El estudio arroja otros datos que dan que pensar, como que el interés por la ciencia correlaciona con el índice de democracia de un país, con su gasto en I+D, con el índice de justicia social y con el índice de coherencia social, aunque curiosamente no con el índice de desigualdad Gini ni con el acceso a la educación. Mastiquemos estos datos antes de que los resultados del siguiente informe nos quiten el apetito.

__________

Tucker-Drob, E. M., Cheung, A. K., & Briley, D. A. (in press). Gross domestic product, science interest, and science achievement: A person x nation interaction. Psychological Science.