Josep Marco-Pallarés y Juan Lupiáñez tuvieron la amabilidad de invitarme a dar un seminario en los másteres que dirigen en la Universitat de Barcelona y la Universidad de Granada, respectivamente. Intenté convencer a los estudiantes de que no deben creerse todo lo que lean en un artículo y les enseñé algunas herramientas estadísticas sencillas que permiten evaluar críticamente cómo de creíbles son los resultados de un estudio. Entre otras cosas, vimos cómo analizar la distribución de valores p, cómo hacer un funnel plot y cómo usar el test de exceso de resultados significativos. Si te interesan estos temas, puedes encontrar información sobre todas estas técnicas en las diapositivas del curso, incluyendo el código necesario para hacer los análisis en R y enlaces a otras aplicaciones online para detectar sesgos.

Tag Archives: sesgo de publicación

Cognitive biases, error management theory, and the reproducibility of research findings

The human mind is the end product of hundreds of thousands of years of relentless natural selection. You would expect that such an exquisite piece of software should be capable of representing reality in an accurate and objective manner. Yet decades of research in cognitive science show that we fall prey to all sorts of cognitive biases and that we systematically distort the information we receive. Is this the best evolution can achieve? A moment’s thought reveals that the final goal of evolution is not to develop organisms with exceptionally accurate representations of the environment, but to design organisms good at surviving and reproducing. And survival is not necessarily about being rational, accurate, or precise. The target goal is actually to avoid making mistakes with fatal consequences, even if the means to achieve this is to bias and distort our perception of reality. Read the post in Imperfect Cognitions.

¿Sirve de algo entrenar la memoria de trabajo?

Dice la canción que tres cosas hay en la vida: salud, dinero y amor. Si hubiera que añadir una cuarta, mi voto va para la memoria de trabajo (MT). Es uno de esos constructos mágicos que parece predecirlo casi todo en la vida: capacidad lectora, rendimiento en matemáticas, aprendizaje de idiomas… De todo. Ante esta evidencia, es tentador pensar que entrenando la MT se podría desarrollar cualquier capacidad cognitiva. Si esto fuera cierto, el rendimiento intelectual podría mejorarse fácilmente mediante sencillos juegos de ordenador que nos obligaran a ejercitar la MT. Y, en efecto, decenas de estudios parecen (o parecían) sugerir que estos programas de entrenamiento funcionan. Sin embargo, un artículo recién publicado por Monica Melby-Lervåg, Thomas Redick y Charles Hulme desafía esta conclusión.

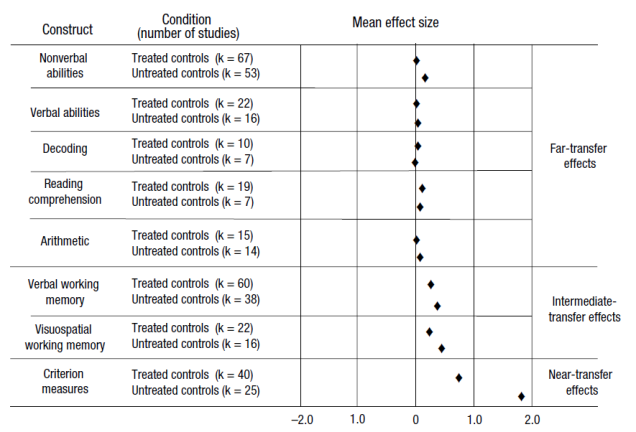

El artículo presenta un meta-análisis de 145 comparaciones experimentales publicadas en 87 artículos. Los resultados pueden resumirse en la figura que reproduzco bajo estas líneas. La columna de la derecha diferencia tres tipos de estudios, dependiendo de si se comprueba el efecto del entrenamiento en habilidades similares a las entrenadas (near-transfer effects), parcialmente similares a las entrenadas (intermediate-transfer effects) o totalmente diferentes a las entrenadas (far-transfer effects). Un primer patrón que puede observarse es que los efectos sólo son grandes en las dos primeras categorías. Entre los estudios que exploran el efecto del entrenamiento sobre habilidades lejanas, los efectos son siempre cercanos a cero.

La figura también clasifica los estudios en función de si utilizan un grupo de control “no tratado” o un grupo de control “tratado”. Los primeros son estudios donde los participantes del grupo de control no realizan ninguna actividad mientras los participantes del grupo experimental reciben el tratamiento. Como puede verse en la figura, los estudios que utilizan este tipo de grupo control pasivo son los que arrojan resultados más prometedores. Por desgracia, este tipo de grupo de control deja mucho que desear. Sería como comprobar la eficacia de una medicina utilizando como control a un grupo de personas que no consume ningún medicamento alternativo, ni siquiera un placebo.

El resultado más interesante del artículo, a mi juicio, es el análisis de la distribución de valores-p. En cualquier área de investigación “sana”, donde se exploran efectos reales, la distribución de valores-p suele mostrar asimetría a la derecha. Esto es, hay muchos más estudios con valores-p entre 0.00 y 0.01 que entre 0.04 y 0.05. La gráfica 3 del artículo, que reproduzco a la izquierda, muestra justo el patrón contrario entre los estudios que utilizaron controles “tratados”. Este tipo de distribución plana -o incluso con asimetría a la izquierda- es el que suele observarse en presencia de falsos positivos. De hecho, aunque los autores son demasiado benévolos para discutir esta posibilidad, la asimetría a la izquierda sugiere que estos estudios podrían estar sesgados por cierta dosis de p-hacking. Es decir, que los datos podrían haberse analizado una y otra vez de diversas maneras hasta que, por azar, se obtuvieron resultados significativos.

El resultado más interesante del artículo, a mi juicio, es el análisis de la distribución de valores-p. En cualquier área de investigación “sana”, donde se exploran efectos reales, la distribución de valores-p suele mostrar asimetría a la derecha. Esto es, hay muchos más estudios con valores-p entre 0.00 y 0.01 que entre 0.04 y 0.05. La gráfica 3 del artículo, que reproduzco a la izquierda, muestra justo el patrón contrario entre los estudios que utilizaron controles “tratados”. Este tipo de distribución plana -o incluso con asimetría a la izquierda- es el que suele observarse en presencia de falsos positivos. De hecho, aunque los autores son demasiado benévolos para discutir esta posibilidad, la asimetría a la izquierda sugiere que estos estudios podrían estar sesgados por cierta dosis de p-hacking. Es decir, que los datos podrían haberse analizado una y otra vez de diversas maneras hasta que, por azar, se obtuvieron resultados significativos.

Estos resultados revisten una especial importancia para el diseño de intervenciones educativas para niños con problemas de aprendizaje. Entre algunos profesionales comenzaba a cuajar la idea de que estos problemas podían paliarse mediante el entrenamiento de la MT. Los resultados de este meta-análisis sugieren que este tipo de prácticas están seguramente avocadas al fracaso.

__________

Melby-Lervag, M., Redick, T. S., & Hulme, C. (2016). Working memory training does not improve performance on measures of intelligence or other measures of “far transfer”: Evidence from a meta-analytic review. Perspectives on Psychological Science, 11, 512-534.